Làm thế nào để tận dụng tối đa thế kỷ quan trọng nhất?

Holden Karnofsky

09/2021

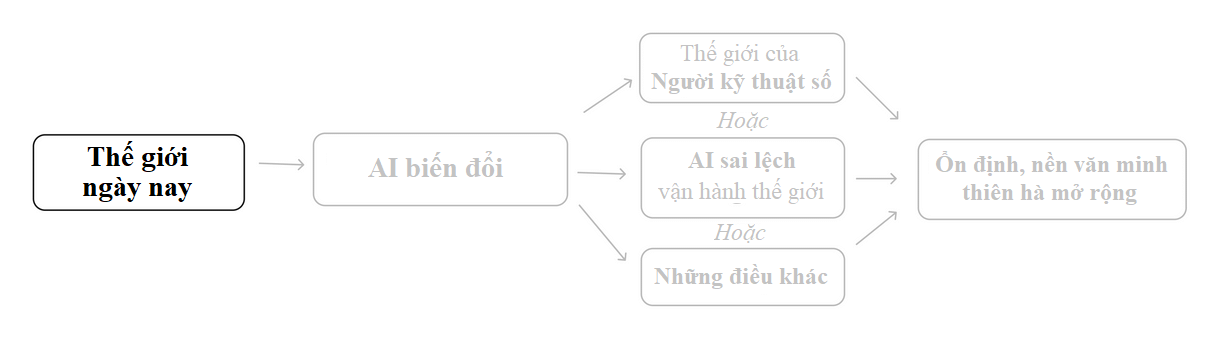

Trong loạt các bài viết "Thế kỷ quan trọng nhất", tôi đã lập luận rằng khả năng cao [1] những thập kỷ tới sẽ chứng kiến:

- Sự phát triển của công nghệ như PASTA (quy trình tự động hóa tiến bộ khoa học và công nghệ).

- Kết quả của bùng nổ năng suất dẫn đến sự phát triển của các công nghệ biến đổi tiếp theo.

- Hạt giống của nền văn minh ổn định trên toàn thiên hà, có thể đặc trưng bởi người kỹ thuật số, hoặc có thể bị điều khiển bởi AI lệch căn chỉnh.

Đây là một quan điểm lạc quan hay bi quan về thế giới? Đối với tôi, nó vừa là cả hai, vừa không phải cả hai, vì chuỗi sự kiện này có thể kết thúc rất tốt hoặc rất xấu cho thế giới, tùy thuộc vào chi tiết trong cách nó diễn ra.

Khi tôi nói về việc sống trong "thế kỷ quan trọng nhất", tôi không chỉ muốn nói rằng những sự kiện quan trọng sẽ xảy ra. Tôi muốn nói rằng chúng ta, những người sống trong thế kỷ này, có cơ hội tác động lớn đến hàng tỷ người, nếu chúng ta có thể hiểu rõ tình hình đủ để tìm ra những hành động hữu ích.

Nhưng cũng quan trọng là phải hiểu tại sao đó là một "nếu" lớn, tại sao thế kỷ quan trọng nhất lại đặt ra một bức tranh chiến lược đầy thách thức, khiến nhiều việc chúng ta có thể làm có thể làm cho tình hình tốt hơn hoặc xấu đi (và khó nói được điều nào).

Trong bài viết này, tôi sẽ trình bày hai khung nhìn đối lập về cách tận dụng tốt nhất thế kỷ quan trọng nhất:

- Khung "Thận trọng". Trong khung này, nhiều kết quả tồi tệ nhất xuất phát từ việc phát triển thứ gì đó như PASTA một cách quá nhanh, vội vàng hoặc liều lĩnh. Chúng ta cần đạt được sự phối hợp (có thể là toàn cầu) để giảm bớt áp lực cạnh tranh và thực hiện các biện pháp thận trọng phù hợp. (Thận trọng)

- Khung "Cạnh tranh". Khung này tập trung không vào cách và thời điểm khi PASTA phát triển, mà ai (các chính phủ nào, các công ty nào, v.v.) sẽ là những người đầu tiên hưởng lợi kết quả của việc bùng nổ năng suất. (Cạnh tranh)

- Những người theo khung "thận trọng" và những người theo khung "cạnh tranh" thường ủng hộ các hành động rất khác nhau, thậm chí trái ngược nhau. Các hành động trông quan trọng đối với những người trong cùng một khung thường trông có hại đối với những người trong khung kia.

- Tôi lo ngại rằng khung "cạnh tranh" sẽ bị đánh giá quá cao theo mặc định, và sẽ thảo luận lý do ở bên dưới. (Xem thêm)

- Để có cái nhìn rõ ràng hơn về sức nặng của các khung này và những hành động nào có khả năng giúp ích nhất, chúng ta cần có tiến bộ hơn trong việc giải quyết các câu hỏi mở về quy mô của các loại rủi ro khác nhau từ AI biến đổi. (Câu hỏi mở)

- Trong khi đó, có một số hành động hữu ích mạnh mẽ và có khả năng cải thiện triển vọng của nhân loại dù sao đi nữa. (Hành động hữu ích mạnh mẽ)

Khung "thận trọng"

Tôi lập luận rằng có một cơ hội tốt khi thế kỷ này sẽ chứng kiến sự chuyển đổi sang một thế giới nơi người kỹ thuật số hoặc AI lệch căn chỉnh (hoặc một thứ gì đó hoàn toàn khác biệt so với con người ngày nay) trở thành lực lượng chủ đạo trong các sự kiện toàn cầu.

Khung "thận trọng" nhấn mạnh rằng một số loại chuyển đổi dường như tốt hơn những loại khác. Danh sách sắp xếp từ loại tệ nhất đến tốt nhất:

Tồi tệ nhất: AI lệch căn chỉnh

Tôi đã thảo luận về khả năng này trước đây, dựa trên nhiều cuộc thảo luận khác và kỹ lưỡng hơn.[2] Ý tưởng cơ bản là các hệ thống AI có thể phát triển mục tiêu riêng của mình và tìm cách mở rộng khắp không gian để thực hiện những mục tiêu đó. Con người, và/hoặc tất cả giá trị của con người, có thể bị đẩy sang một bên (hoặc bị tuyệt chủng, nếu không chúng ta sẽ gây cản trở).

Tồi tệ thứ hai:[3]Sự trưởng thành của công nghệ đối kháng

Nếu chúng ta đạt đến điểm mà có người kỹ thuật số và/hoặc (AI không sai lệch) có thể sao chép bản thân mà không giới hạn, và rồi mở rộng khắp không gian, có thể sẽ cần áp lực mạnh mẽ để di chuyển, và nhân lên (thông qua sao chép) nhanh nhất có thể để giành được nhiều ảnh hưởng hơn trên thế giới. Điều này sẽ dẫn đến các quốc gia/liên minh cố gắng vượt qua nhau một cách điên cuồng, và/hoặc xung đột quân sự trực tiếp, biết rằng nhiều thứ có thể bị đe dọa trong thời gian ngắn.

Tôi dự đoán rằng kiểu động lực này sẽ có nguy cơ khiến cho nhiều thiên hà rơi vào tình trạng tồi tệ. [4]

Một trạng thái tồi tệ như vậy có thể là "vĩnh viễn nằm dưới sự kiểm soát của một cá nhân (số) duy nhất (và/hoặc các bản sao của họ)". Do khả năng tạo ra các nền văn minh ổn định của người số, có vẻ như một chế độ toàn trị sẽ vĩnh viễn tồn tại lâu dài trên các khu vực đáng kể của dải ngân hà.

Con người/các quốc gia/liên minh nghi ngờ lẫn nhau về nguy cơ này, về tiềm năng thiết lập các nền văn minh ổn định dưới sự kiểm soát của họ, có thể cạnh tranh và/hoặc tấn công lẫn nhau từ sớm để ngăn chặn điều này. Điều này có thể dẫn đến chiến tranh với kết quả khó lường (do những tiến bộ công nghệ khó lường PASTA mang lại).

Tốt thứ hai: Đàm phán và quản trị

Các quốc gia có thể ngăn chặn động thái trưởng thành của công nghệ đối kháng này bằng cách lập kế hoạch trước và đàm phán với nhau. Ví dụ, có thể mỗi quốc gia hoặc mỗi cá nhân được phép tạo ra một số lượng người kỹ thuật số nhất định (tuân theo các quy định về quyền con người và các quy định khác), giới hạn trong một khu vực không gian nhất định.

Dường như có một phạm vi rất lớn về các chi tiết tiềm năng cụ thể khác nhau ở đây, một số tốt và công bằng hơn nhiều so với những cái khác.

Tốt nhất: Soi chiếu

Thế giới có thể đạt được mức độ phối hợp đủ cao để hoãn bất kỳ bước đi không thể đảo ngược nào (bao gồm cả việc khởi động động thái Sự trưởng thành của công nghệ đối kháng).

Sau đó, có thể có điều gì đó tương tự như "Thời kỳ Phản tư Dài" mà Toby Ord (trong cuốn sách Vực thẳm) đề cập:[5] một khoảng thời gian kéo dài trong đó con người có thể cùng nhau quyết định mục tiêu và hy vọng cho tương lai, lý tưởng nhất là đại diện cho sự thỏa hiệp công bằng nhất có thể giữa các quan điểm khác nhau. Công nghệ tiên tiến nghĩ được có thể giúp cho quá trình này diễn ra tốt hơn nhiều so với hiện tại. [6]

Có vô số câu hỏi về cách thức hoạt động của "quá trình soi chiếu" như vậy, và liệu có thực sự có hy vọng nào về khả năng nó đạt được một kết quả tương đối tốt và công bằng. Những chi tiết như "loại người kỹ thuật số nào được tạo ra trước tiên" có thể vô cùng quan trọng. Hiện tại, ít có cuộc thảo luận về loại chủ đề này.[7]

Khác

Có thể có nhiều loại chuyển đổi khác mà tôi chưa đề cập ở đây.

Vai trò của sự thận trọng

Nếu thứ tự trên là chính xác, thì tương lai của thiên hà sẽ trông tươi sáng hơn đến mức:

- Tránh được AI lệch căn chỉnh: các hệ thống AI mạnh mẽ hoạt động để giúp con người, thay vì theo đuổi mục tiêu của riêng chúng.

- Tránh được Sự trưởng thành trong công nghệ đối kháng: Điều này có nghĩa là con người không triển khai các hệ thống AI tiên tiến, hoặc các công nghệ chúng có thể mang lại, theo cách đối kháng (trừ khi điều này trở nên cần thiết để ngăn chặn điều tồi tệ hơn).

- Đạt được đủ sự phối hợp để các nhân tố chủ chốt có thể "có thời gian làm", và việc Soi chiếu trở nên khả thi.

Lý tưởng nhất, mọi người có tiềm năng xây dựng thứ gì đó tương tự PASTA đều có thể tập trung năng lượng vào việc xây dựng thứ gì đó an toàn (không lệch hướng), và cẩn thận lập kế hoạch (và đàm phán với các bên khác về) cách triển khai, mà không vội vàng hay cạnh tranh. Với suy nghĩ này, có lẽ chúng ta nên làm những việc như:

- Cố gắng cải thiện niềm tin và hợp tác giữa các năng lực cường quốc thế giới. Có thể thông qua các phiên bản tập trung vào AI của Pugwash (một hội nghị quốc tế nhằm giảm thiểu rủi ro xung đột quân sự), hoặc bằng cách phản đối các động thái ngoại giao hiếu chiến.

- Khuyến khích các chính phủ và nhà đầu tư đổ tiền vào nghiên cứu AI, khuyến khích các phòng thí nghiệm AI xem xét kỹ lưỡng các hậu quả của nghiên cứu trước khi công bố hoặc mở rộng quy mô, v.v. Làm chậm lại theo cách này có thể tạo ra thêm thời gian để nghiên cứu về việc tránh AI lệch căn chỉnh, thêm thời gian để xây dựng các cơ chế tin cậy và hợp tác, thêm thời gian để đạt được sự rõ ràng về mặt chiến lược nói chung, và giảm khả năng xảy ra động thái Trưởng thành của công nghệ đối kháng.

Khung "cạnh tranh"

(Lưu ý: Có một vài khả năng nhầm lẫn giữa khái niệm "cạnh tranh" và khái niệm Trưởng thành trong công nghệ đối kháng, vì vậy tôi đã cố gắng sử dụng các thuật ngữ hoàn toàn khác nhau. Tôi sẽ giải thích sự khác biệt này trong phần chú thích.[8])

Khung "cạnh tranh" tập trung ít hơn vào cách chuyển đổi sang một tương lai hoàn toàn khác biệt diễn ra như thế nào, và nhiều hơn vào việc ai là người đưa ra các quyết định quan trọng trong quá trình đó.

- Nếu một thứ gì đó như PASTA được phát triển chủ yếu (hoặc đầu tiên) ở quốc gia X, thì chính phủ của quốc gia X có thể đưa ra nhiều quyết định quan trọng về việc có nên và điều chỉnh sự bùng nổ tiềm năng của các công nghệ mới như thế nào.

- Ngoài ra, những cá nhân và tổ chức dẫn đầu trong tiến bộ AI và các công nghệ khác vào thời điểm đó có thể có ảnh hưởng đặc biệt lớn lên các quyết định đó.

Điều này có nghĩa là việc "ai dẫn đầu trong lĩnh vực AI biến đổi", quốc gia hoặc các quốc gia nào, cá nhân hoặc tổ chức nào - có thể là vấn đề vô cùng quan trọng.

- Liệu các chính phủ dẫn đầu trong lĩnh vực AI biến đổi có phải là các chế độ độc tài không?

- Các chính phủ nào có khả năng hiểu rõ nhất (một cách hiệu quả) về rủi ro và lợi ích khi đưa ra các quyết định quan trọng?

- Các chính phủ nào ít có khả năng sử dụng công nghệ tiên tiến nhất để củng cố quyền lực và sự thống trị của một nhóm? (Thật không may, tôi không thể nói có bất kỳ quốc gia nào mà tôi cảm thấy hài lòng ở đây). Quốc gia nào có khả năng cao nhất để giữ mở khả năng cho những thứ như "tránh các kết quả bị khóa chặt, để thời gian cho tiến bộ chung trên toàn cầu nâng cao các khả năng có kết quả tốt cho tất cả mọi người?"

- Các câu hỏi tương tự áp dụng cho những cá nhân và tổ chức dẫn đầu trong lĩnh vực AI biến đổi. Những cá nhân và tổ chức nào có khả năng thúc đẩy mọi thứ theo hướng tích cực cao nhất?

Một số người cảm thấy rằng ngày nay chúng ta có thể đưa ra những tuyên bố tự tin về các quốc gia cụ thể, và/hoặc những cá nhân và tổ chức nào mà chúng ta nên hy vọng sẽ dẫn đầu trong lĩnh vực AI biến đổi. Những người này có thể ủng hộ các hành động như:

- Tăng khả năng về các hệ thống PASTA đầu tiên được xây dựng ở những quốc gia ít độc tài hơn, điều này tức là, như kiểu thúc đẩy đầu tư và sự chú ý vào phát triển AI ở những quốc gia này.

- Hỗ trợ và cố gắng đẩy nhanh các phòng thí nghiệm AI do những người có khả năng đưa ra các quyết định sáng suốt (về các vấn đề như cách tương tác với chính phủ, hệ thống AI nào nên công bố và triển khai so với giữ bí mật, v.v.)

Tại sao tôi lo sợ "cạnh tranh" bị đánh giá quá cao so với "thận trọng"

Theo mặc định, tôi dự đoán rằng nhiều người sẽ hướng đến khung "cạnh tranh" hơn là khung "thận trọng" - vì những lý do mà tôi cho là không tốt, chẳng hạn như:

- Tôi nghĩ mọi người tự nhiên hào hứng hơn với việc "giúp những người tốt đánh bại kẻ xấu" hơn là "giúp tất cả chúng ta tránh một kết quả tồi tệ chung, vì những lý do vô nhân đạo như 'chúng ta đã thiết kế các hệ thống AI cẩu thả' hoặc 'chúng ta đã tạo ra một động lực trong đó sự vội vàng và hung hăng lại được thưởng'".

- Tôi dự đoán mọi người sẽ có xu hướng tự tin quá mức về những quốc gia, tổ chức hoặc cá nhân mà họ coi là "những người tốt".

- Việc ủng hộ khung "cạnh tranh" thường dẫn đến việc thực hiện các hành động như: nỗ lực đẩy nhanh sự phát triển AI của quốc gia hoặc tổ chức cụ thể - những hành động mang lại lợi nhuận, hấp dẫn và dễ tạo động lực một cách tự nhiên. Việc ủng hộ khung "thận trọng" thì ít mang tính chất này hơn.

- Những mối quan tâm lớn nhất mà khung "thận trọng" tập trung vào là AI lệch căn chỉnh và Sự trưởng thành của công nghệ đối kháng, là những thứ có phần trừu tượng và khó tóm gọn để hiểu. Theo nhiều cách, chúng dường như là những rủi ro có mức độ nghiêm trọng cao nhất, nhưng cảm thấy sợ hãi một cách bản năng trước việc "tụt hậu so với các quốc gia/tổ chức/con người khiến tôi sợ hãi" lại dễ dàng hơn so với chuyện cảm thấy sợ hãi một cách bản năng trước điều gì đó như "Kết quả xấu cho tương lai lâu dài của vũ trụ vì chúng ta đã vội vàng trong thế kỷ này."

- Tôi nghĩ AI lệch căn chỉnh là một rủi ro đặc biệt khó để nhiều người coi trọng. Nó nghe có vẻ kỳ quặc và giống như khoa học viễn tưởng; những người lo lắng về nó thường bị hiểu là đang hình dung điều gì đó như Kẻ hủy diệt, và những lo ngại chi tiết hơn của họ khó có thể được hiểu.

- Tôi hy vọng sẽ đăng thêm các bài viết trong tương lai để giúp mọi người có cái nhìn trực quan về lý do tại sao tôi cho rằng AI lệch căn chỉnh là một rủi ro thực sự.

Để tránh hiểu lầm, tôi sẽ khẳng định rằng khung "thận trọng" có rất nhiều ưu điểm. Đặc biệt, AI lệch căn chỉnh và độ trưởng thành của công nghệ đối kháng dường như rất tồi tệ hơn các loại chuyển đổi tiềm năng khác, và cả hai đều có khả năng thực sự làm cho toàn bộ tương lai của loài người (và các thế hệ sau) trở nên tồi tệ hơn nhiều so với những gì có thể.

Tôi lo ngại rằng việc quá tập trung vào khung "cạnh tranh" sẽ dẫn đến việc đánh giá thấp rủi ro lệch căn chỉnh và vội vàng triển khai các hệ thống không an toàn, không thể dự đoán được, điều này có thể gây ra nhiều hậu quả tiêu cực.

Với điều đó, tôi đặt sức nặng lớn vào cả hai khung. Tôi vẫn khá không chắc chắn về việc khung nào quan trọng và hữu ích hơn (nếu có).

Các câu hỏi mở quan trọng về "thận trọng" so với "cạnh tranh"

Những người theo khung "thận trọng" và những người theo khung "cạnh tranh" thường ủng hộ các hành động rất khác nhau, thậm chí trái ngược nhau. Các hành động được coi là quan trọng với những người trong một khung thường được coi là bất lợi một cách tích cực đối với những người trong khung kia.

Ví dụ, những người trong khung "cạnh tranh" thường ủng hộ việc phát triển các hệ thống AI mạnh mẽ hơn càng nhanh càng tốt; đối với những người trong khung "thận trọng", sự vội vàng là một trong những điều cần tránh. Những người trong khung "cạnh tranh" thường ủng hộ quan hệ đối đầu với nước ngoài, trong khi những người trong khung "thận trọng" thường muốn mối quan hệ nước ngoài trở nên hợp tác hơn.

(Tuy nhiên, sự phân chia này là một sự đơn giản hóa. Nhiều người, bao gồm cả tôi, lại đồng cảm với cả hai khung. Và mỗi khung có thể ngụ ý những hành động thường được liên kết với khung kia; ví dụ, bạn có thể chọn khung "thận trọng" nhưng cảm thấy rằng cần thiết vội vàng ngay bây giờ để một quốc gia có thể thiết lập một lợi thế đủ rõ ràng trong AI, sau đó có thể từ từ, ưu tiên việc tránh AI lệch căn chỉnh, v.v.)

Tôi mong tôi có thể tự tin nói với bạn nên đặt bao nhiêu sức nặng cho mỗi khung tư duy, và những hành động nào có khả năng hữu ích nhất. Nhưng tôi không thể. Tôi nghĩ chúng ta sẽ có sự rõ ràng hơn nếu có câu trả lời tốt hơn cho một số câu hỏi mở quan trọng:

Câu hỏi mở: Vấn đề căn chỉnh khó đến mức nào?

Con đường tương lai tồi tệ nhất là AI lệch căn chỉnh, trong đó các hệ thống AI cuối cùng sẽ có các mục tiêu lệch căn chỉnh với con người và tìm cách lấp đầy thiên hà theo các mục tiêu đó. Chúng ta nên coi trọng rủi ro này đến mức nào và việc tránh kết quả này sẽ khó khăn đến mức nào? Việc giải quyết "vấn đề căn chỉnh", về cơ bản có nghĩa là có khả năng kỹ thuật để xây dựng các hệ thống không làm điều này, sẽ khó khăn đến mức nào? [9]

- Một số người tin rằng vấn đề căn chỉnh sẽ vô cùng khó khăn; rằng hy vọng duy nhất của chúng ta để giải quyết nó nằm trong một thế giới nơi chúng ta có lượng thời gian khổng lồ và không phải chạy đua để triển khai AI tiên tiến; và rằng việc tránh kết quả "AI lệch căn chỉnh" nên là ưu tiên hàng đầu trong thế kỷ quan trọng nhất. Những người này thường ủng hộ mạnh mẽ các can thiệp "thận trọng" đã mô tả ở trên: họ tin rằng việc vội vàng phát triển AI sẽ làm tăng nguy cơ đã rất lớn của kết quả tồi tệ nhất.

- Một số người tin rằng nó sẽ dễ dàng, và/hoặc rằng toàn bộ ý tưởng về "AI lệch căn chỉnh" là sai lầm, ngớ ngẩn hoặc thậm chí vô nghĩa - lập kế hoạch cho một sự kiện tương lai quá cụ thể. Những người này thường quan tâm hơn đến các can thiệp "cạnh tranh" đã mô tả ở trên: họ tin rằng AI tiên tiến có thể sẽ được sử dụng hiệu quả bởi bất kỳ quốc gia nào (hoặc trong một số trường hợp là liên minh hoặc công ty nhỏ hơn) phát triển nó trước tiên, và vì vậy câu hỏi là ai sẽ phát triển nó trước.

- Và nhiều người nằm ở đâu đó giữa hai quan điểm này.

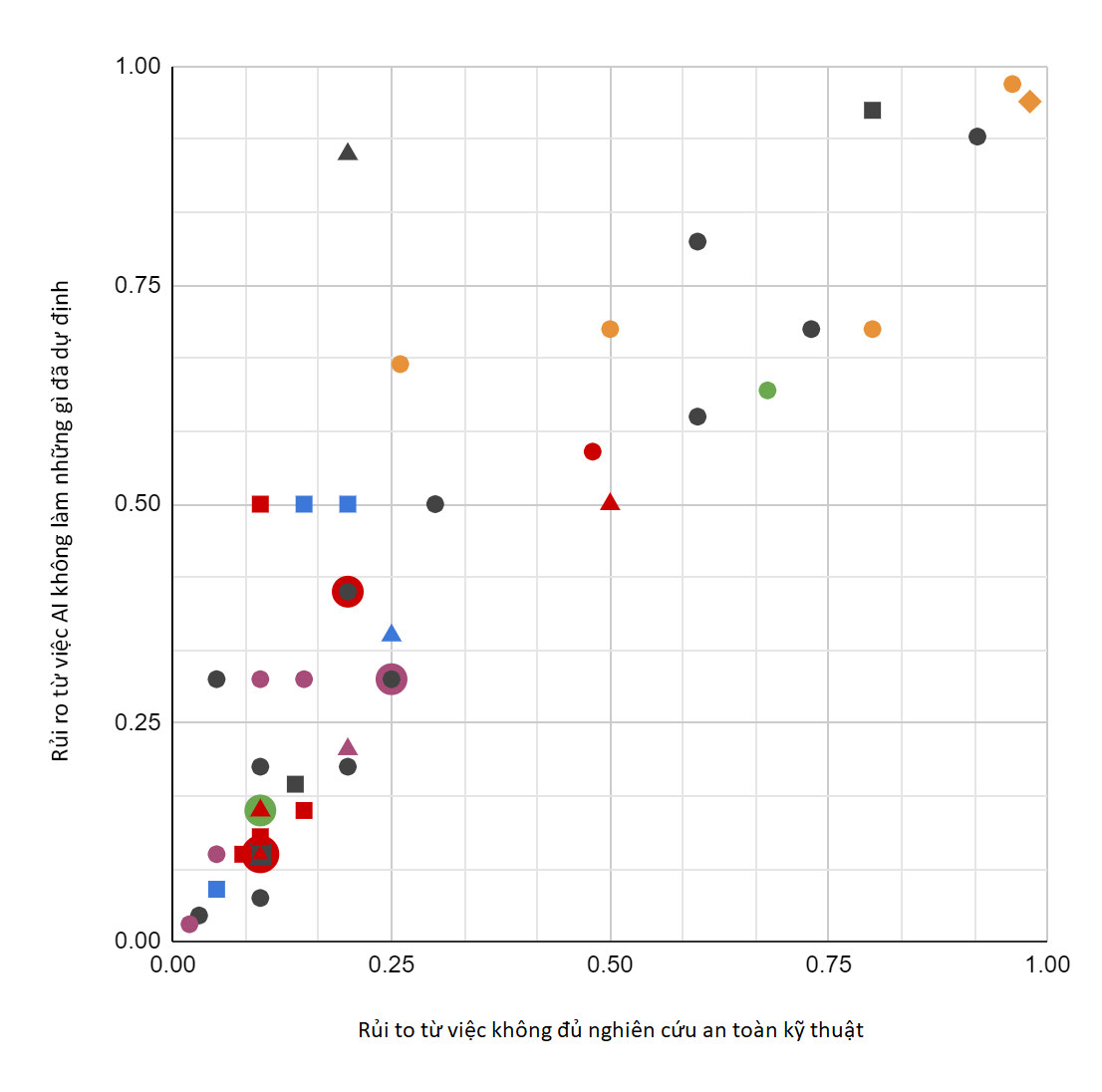

Sự phân tán ở đây là cực kỳ lớn. Ví dụ, hãy xem kết quả này một 'khảo sát hai câu hỏi' không chính thức [được gửi] tới khoảng 117 người làm việc về rủi ro AI lâu dài, hỏi về mức độ rủi ro hiện sinh từ 'con người không nghiên cứu an toàn kỹ thuật AI đủ' và từ 'hệ thống AI không làm/tối ưu hóa những gì những con người triển khai chúng mong muốn/định hướng'". (Như biểu đồ phân tán cho thấy, mọi người đã đưa ra câu trả lời tương tự cho hai câu hỏi).

Chúng ta có những người trả lời cho rằng có <5% khả năng các vấn đề về sự căn chỉnh sẽ làm giảm đáng kể sự tốt đẹp của tương lai; những người trả lời cho rằng có >95% khả năng; và gần như mọi mức độ giữa hai cực đó.[10] Cảm nhận của tôi thì đây là một đại diện công bằng cho tình hình: ngay cả trong số ít người đã dành nhiều thời gian nhất để suy nghĩ về những vấn đề này, hầu như không có sự đồng thuận hay thống nhất về mức độ khó khăn của vấn đề căn chỉnh sẽ như thế nào.

Tôi hy vọng rằng theo thời gian, lĩnh vực nghiên cứu về sự căn chỉnh AI[11] sẽ phát triển, và khi cả AI và nghiên cứu về căn chỉnh AI tiến bộ, chúng ta sẽ có cái nhìn rõ ràng hơn về độ khó của vấn đề căn chỉnh AI. Điều này, ngược lại, có thể làm rõ ràng hơn về việc ưu tiên "thận trọng" so với "cạnh tranh".

Các câu hỏi mở khác

Ngay cả khi chúng ta có cái nhìn rõ ràng về độ khó của vấn đề căn chỉnh, thì vẫn còn rất nhiều câu hỏi phức tạp khác.

Chúng ta có nên kỳ vọng AI biến đổi sẽ xuất hiện trong 10-20 năm tới, hay là muộn hơn nhiều? Các hệ thống AI hàng đầu có thể chuyển từ rất hạn chế sang rất mạnh mẽ một cách nhanh chóng ("cất cánh khó khăn") hay từ từ ("cất cánh chậm")?[12] Chúng ta có nên hy vọng các dự án của chính phủ sẽ đóng vai trò quan trọng trong phát triển AI, hay là AI biến đổi chủ yếu xuất phát từ khu vực tư nhân? Có phải một số chính phủ có khả năng cao hơn những chính phủ khác trong việc hướng tới sử dụng AI biến đổi một cách cẩn thận, bao trùm và nhân văn? Chúng ta nên hy vọng rằng một chính phủ (hoặc công ty) thực sự làm gì nếu nó có khả năng đẩy nhanh đáng kể tiến bộ khoa học và công nghệ thông qua AI?

Với những câu hỏi này và những câu hỏi khác, thường sẽ rất khó để đánh giá một số hành động, như thành lập phòng thí nghiệm AI mới, kêu gọi thận trọng và các biện pháp bảo vệ trong phát triển AI hiện nay, v.v, và xác định xem liệu nó có làm tăng khả năng đạt được kết quả tốt trong dài hạn hay không.

Hành động có giá trị rõ ràng

Mặc dù ở tình trạng không chắc chắn này, nhưng đây là một số việc dường như có giá trị rõ ràng để thực hiện ngay bây giờ:

Nghiên cứu kỹ thuật về vấn đề căn chỉnh. Một số nhà nghiên cứu tập trung vào việc xây dựng các hệ thống AI có thể đạt được "kết quả tốt hơn" (thắng nhiều trò chơi bàn cờ hơn, phân loại hình ảnh chính xác hơn, v.v.). Tuy nhiên, một nhóm các nhà nghiên cứu nhỏ hơn lại tập trung vào các vấn đề như:

- Đào tạo các hệ thống AI để tích hợp phản hồi của con người vào cách chúng thực hiện các tác vụ tóm tắt, nhằm giúp các hệ thống AI phản ánh những sở thích khó định nghĩa của con người, một điều có thể trở nên quan trọng trong tương lai.

- Tìm hiểu cách làm sao để hiểu "hệ thống AI đang suy nghĩ và lập luận như thế nào," để làm cho nó bớt bí ẩn.

- Tìm hiểu cách ngăn chặn hệ thống AI đưa ra những phán đoán cực kỳ sai lầm về các hình ảnh thiết kế để đánh lừa chúng, và các nghiên cứu khác tập trung vào việc giúp hệ thống AI tránh các hành vi “trường hợp tệ nhất".

- Nghiên cứu lý thuyết về cách một hệ thống AI có thể rất tiên tiến nhưng không trở nên khó lường theo những cách sai lầm.

Loại công việc này có thể vừa giảm thiểu rủi ro trong kết quả AI lệch căn chỉnh, và/hoặc mang lại sự rõ ràng hơn về mức độ đe dọa của nó lớn như thế nào. Một số công việc diễn ra trong các trường đại học, một số tại các phòng thí nghiệm AI, và một số trong các tổ chức chuyên môn.

Theo đuổi sự rõ ràng trong chiến lược: tiến hành nghiên cứu có thể giải quyết các câu hỏi quan trọng khác (như những các câu đã liệt kê trên), để giúp làm rõ những hành động cấp thiết nào trông có vẻ hữu ích nhất.

Giúp các chính phủ và xã hội trở nên, vâng, tốt đẹp hơn. Giúp Quốc gia X vượt trội hơn các quốc gia khác trong phát triển AI có thể làm cho tình hình tốt hơn hoặc xấu hơn, vì những lý do đã nêu trên. Nhưng dường như việc hướng tới một Quốc gia X với những giá trị tốt đẹp hơn, bao trùm hơn, và một chính phủ có các nhà ra quyết định chính có khả năng đưa ra những quyết định có suy nghĩ, dựa trên giá trị tốt đẹp, là những điều rất tốt.

Lan tỏa ý tưởng và xây dựng cộng đồng. Hiện nay, theo tôi, thế giới đang rất thiếu những người chia sẻ những kỳ vọng và lo ngại cơ bản nhất định, chẳng hạn như:

- Tin rằng nghiên cứu AI có thể dẫn đến những thay đổi nhanh chóng, triệt để ở mức độ cực đoan như đã nêu ở đây (vượt xa những vấn đề như tăng tỷ lệ thất nghiệp).

- Tin rằng vấn đề căn chỉnh (được thảo luận ở trên) ít nhất là một lo ngại có cơ sở, và nghiêm túc xem xét khung "thận trọng".

- Xem xét toàn bộ tình hình qua lăng kính "Hãy cố gắng đạt được kết quả tốt nhất có thể cho toàn thế giới trong tương lai dài hạn", thay vì các lăng kính phổ biến hơn như "Hãy cố gắng kiếm tiền" hoặc "Hãy cố gắng đảm bảo rằng đất nước của tôi dẫn đầu thế giới trong nghiên cứu AI".

Tôi cho rằng việc có thêm nhiều người có lăng kính cơ bản này là rất quý giá, đặc biệt là những người làm việc tại các phòng thí nghiệm AI và chính phủ. Nếu và khi chúng ta có sự rõ ràng trong chiến lược hơn về những hành động có thể tối đa hóa khả năng thành công của "thế kỷ quan trọng nhất", tôi kỳ vọng những người này sẽ ở vị trí tương đối thuận lợi để góp phần hữu ích.

Một số tổ chức và cá nhân đã nỗ lực giới thiệu góc nhìn trên cho mọi người và giúp họ kết nối với những người chia sẻ quan điểm này. Tôi cho rằng đã có tiến bộ đáng kể (về mặt phát triển cộng đồng) từ những nỗ lực này.

Đóng góp? Người ta có thể đóng góp ngay hôm nay cho các tổ chức như này. Nhưng tôi phải thừa nhận rằng, nói chung, hiện tại không có sự chuyển đổi dễ dàng giữa "tiền" và "cải thiện khả năng thế kỷ quan trọng nhất diễn ra suôn sẻ". Không phải là nếu ai đó chỉ đơn giản là gửi, ví dụ, $1 nghìn tỷ đến đúng nơi, là chúng ta có thể thở dễ dàng về các thách thức như vấn đề căn chỉnh và nguy cơ của các xã hội kỹ thuật số u ám.

Theo tôi, chúng ta, với tư cách là loài người, hiện đang thiếu trầm trọng những người bày tỏ bất kỳ sự quan tâm đến những thách thức quan trọng nhất phía trước và chưa làm việc để có sự rõ ràng chiến lược về những hành động cụ thể cần thực hiện. Chúng ta không thể giải quyết vấn đề này bằng cách ném tiền vào nó.[13] Đầu tiên, chúng ta cần coi trọng nó hơn và hiểu nó tốt hơn.

*Chú thích:

- Từ Dự báo AI Biến đổi: "Bằng chứng ở đâu?": "Tôi dự báo có hơn 10% khả năng AI biến đổi sẽ phát triển trong vòng 15 năm (đến năm 2036); khoảng 50% khả năng nó sẽ phát triển trong vòng 40 năm (đến năm 2060); và khoảng 2/3 khả năng nó sẽ phát triển trong thế kỷ này (đến năm 2100)." Xem thêm Một số chi tiết bổ sung về ý nghĩa của "thế kỷ quan trọng nhất" ↩︎

- Các tài liệu bao gồm các cuốn sách Siêu trí tuệ, Tương thích với con người, Cuộc sống 3.0 và Vấn đề căn chỉnh. Bản trình bày ngắn gọn và dễ tiếp cận nhất tôi biết là Lý do tại sao nên coi AI là mối đe dọa nghiêm trọng đối với nhân loại (bài viết trên Vox của Kelsey Piper). Báo cáo về rủi ro tồn vong từ AI tìm kiếm quyền lực của Joe Carlsmith từ Từ thiện mở trình bày tập hợp các tiền đề chi tiết, khi kết hợp lại sẽ cho thấy vấn đề này là nghiêm trọng. ↩︎

- Trật tự của sự tốt đẹp không phải là tuyệt đối, tất nhiên. Có những phiên bản của "Sự trưởng thành trong công nghệ đối kháng" có thể tồi tệ hơn "AI lệch căn chỉnh" - ví dụ, nếu phiên bản trước dẫn đến quyền lực rơi vào tay những kẻ cố ý gây ra đau khổ. ↩︎

- Một phần lý do là các bên di chuyển nhanh hơn, cẩn thận hơn có thể nhanh chóng vượt trội về số lượng và quyết định tương lai của thiên hà. Cũng có rủi ro lâu dài được thảo luận trong cuốn Tương lai về tiến hóa nhân loại của Nick Bostrom; xem thêm bài thảo luận về ý tưởng của Bostrom trên Slate Star Codex, tuy nhiên cũng xem bài viết của Carl Shulman cho rằng động lực này ít khả năng dẫn đến việc loại bỏ hoàn toàn những điều tốt đẹp. ↩︎

- Xem trang 191. ↩︎

- Ví dụ, xem phần này của Người kỹ thuật số thậm chí là vấn đề lớn hơn nữa. ↩︎

- Một bài báo liên quan: Chính sách công và Trí tuệ nhân tạo siêu thông minh: Cách tiếp cận trường vectơ của Bostrom, Dafoe và Flynn. ↩︎

- Sự trưởng thành công nghệ đối kháng đề cập đến một thế giới trong đó công nghệ tiên tiến đã được phát triển, có thể với sự trợ giúp của trí tuệ nhân tạo, và các liên minh khác nhau đang cạnh tranh để giành ảnh hưởng trên thế giới. Ngược lại, "Cạnh tranh" đề cập đến một chiến lược về cách hành động trước khi AI tiên tiến phát triển. Ta có thể hình dung một thế giới trong đó có chính phủ hoặc liên minh nào đó áp dụng khung "cạnh tranh", phát triển AI tiên tiến trước các bên khác, và sau đó đưa ra một loạt quyết định tốt để ngăn chặn Sự trưởng thành của công nghệ đối kháng. (Hoặc ngược lại, một thế giới trong đó việc thất bại trong "cạnh tranh" làm tăng nguy cơ của trưởng thành của công nghệ đối kháng.) ↩︎

- Xem định nghĩa về vấn đề này tại Wikipedia và Paul Christiano's Medium. ↩︎

- Một cuộc khảo sát chi tiết và riêng tư thực hiện ở báo cáo này, hỏi về xác suất "thảm họa" trước năm 2070 do loại vấn đề thảo luận trong báo cáo, đã nhận được câu trả lời dao động từ <1% đến >50%. Theo ý kiến của tôi, có những người rất suy nghĩ kỹ lưỡng đã nghiêm túc xem xét các vấn đề này ở cả hai đầu của khoảng đó. ↩︎

- Một số ví dụ về chủ đề kỹ thuật tại đây. ↩︎

- Một số thảo luận về chủ đề này tại đây: Phân biệt các định nghĩa về sự bùng nổ - Diễn đàn AI căn chỉnh ↩︎

- Một số suy nghĩ thêm về "khi tiền không đủ" tại bài viết cũ của GiveWell. ↩︎